如何在CF中使用GPU加速?

- 游戏攻略

- 2025-05-12

- 33

- 更新:2025-05-09 16:15:10

近年来,随着图形处理单元(GPU)技术的飞速发展,GPU加速已成为提高计算效率和性能的关键技术之一。尤其是在计算密集型任务中,例如在流行的编程竞赛平台Codeforces(简称CF)中进行算法竞赛时,学会利用GPU加速可显著提升代码的执行速度,从而在竞赛中占据优势。本文将详细介绍如何在CF中使用GPU加速,为您提供从理论到实践的全面指南。

GPU加速的基础概念

在探讨如何在CF中使用GPU加速之前,我们需要了解GPU加速的基本原理。GPU,即图形处理器,最初设计用于处理图形和视频渲染任务。与CPU相比,GPU拥有更多的核心,能够同时处理更多的并行任务,因此在进行大规模并行计算时具有独特优势。在CF等算法竞赛中,某些算法和数据处理任务可以并行化,这为GPU加速提供了可能。

如何在CF中使用GPU加速

1.确认环境支持

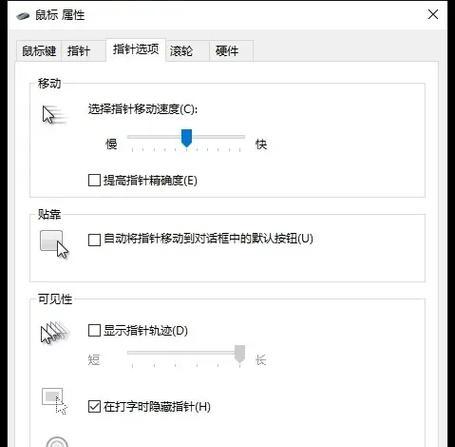

需要确保你的机器配备了支持CUDA或OpenCL等技术的GPU。CF的某些问题可能需要特定版本的GPU驱动程序支持,因此检查和更新驱动程序是必要的第一步。

2.掌握GPU编程基础

在开始利用GPU加速之前,你需要掌握一些基础的GPU编程知识。CUDA(ComputeUnifiedDeviceArchitecture)是由NVIDIA推出的一种通用并行计算架构,是目前最主流的GPU编程平台之一。通过学习CUDA编程,你可以编写可以在GPU上运行的程序,这些程序可以处理大量并行任务。

3.了解CF平台对GPU的支持

CF并不直接支持GPU加速。如果你希望在CF上使用GPU加速,你将需要在本地环境中编写和测试你的GPU代码。在参加比赛时,你需要提交算法的CPU版本。

4.在本地环境中编写GPU加速代码

在本地环境中,你可以使用CUDA编程来对你的算法进行GPU加速。你需要编写一个主函数(运行在CPU上)和一个内核函数(运行在GPU上)。内核函数是用于执行并行任务的部分。

5.测试和优化GPU代码

使用本地测试集来验证GPU代码的正确性和性能。对GPU代码进行性能分析,并对代码进行优化以获得最佳性能。

高级技巧与常见问题

高级技巧:

内存管理:GPU加速编程中,合理管理GPU内存是提高性能的关键。需要尽量避免内存的频繁传输和不必要的内存操作。

并行策略:并非所有任务都适合GPU加速。了解如何分析问题的可并行性,以及如何设计高效的并行策略至关重要。

常见问题:

驱动程序问题:不正确的驱动程序版本可能会导致GPU加速程序运行失败。确保你的GPU驱动程序是最新的,并且与你的CUDA版本兼容。

性能瓶颈:有时候,尽管使用了GPU加速,但性能提升并不明显。这可能是由于算法本身不适合并行化,或者GPU与CPU之间的通信成为瓶颈。

实战案例与分析

为了更深入地了解如何在CF中使用GPU加速,我们来分析一个实战案例。假设我们在CF上遇到了一个需要进行大规模矩阵运算的问题。我们可以使用CUDA编写一个GPU加速版本的矩阵乘法算法,然后在本地环境中进行测试。

1.矩阵乘法的GPU实现

我们需要编写一个CUDA内核函数,该函数能够并行地执行矩阵乘法中的一个元素计算。我们需要编写CPU端的代码来分配GPU内存、拷贝数据到GPU内存,并启动内核函数。

2.测试与性能对比

通过将GPU版本与CPU版本的矩阵乘法进行对比测试,我们可以看到GPU加速带来的性能提升。通常,对于大规模矩阵运算,GPU版本会比CPU版本快很多。

结语

掌握如何在CF中使用GPU加速,可以显著提高解决复杂算法问题的能力。虽然CF平台本身不支持GPU加速,但在本地环境中学会利用这一技术,无疑将为你在编程竞赛中提供强大的竞争力。通过本文的介绍,相信你已经对GPU加速有了深入的理解,并且能够将其运用到实际的算法竞赛中。不断实践和优化,你将能够更好地驾驭这项技术,让其成为你技术栈中的重要武器。